فهرست

اگر قرار است وب سایت شما در صفحات نتایج جستجو رتبه بندی شود، باید از قبل ایندکس شود. اگر قرار است ایندکس شود، باید خزیده شود. خزیدن و ایندکس شدن دو فرآیندی هستند که اساساً به عملکرد سئو وب سایت شما کمک میکنند. در این راهنما، توضیح میدهیم که فرآیندهای کرال شدن به چه معنا هستند و چگونه میتوانید خزیدن و ایندکسی را برای بهترین رتبه ممکن بهینه کنید.

کرال شدن سایت چیست؟

خزیدن یا کرال شدن اساس اصلی ایندکس شدن است. خزنده – که عنکبوت یا ربات نیز نامیده میشود – از طریق لینک در وب سایتها حرکت میکند و محتوای وب سایت شما را ارزیابی می کند. این خزندهها که با نام کرالر نیز شناخته میشوند،در حال خزیدن سایت شما بررسی میکنند که آی میتوان آن صفحه (صفحهای که در حال کرال شدن است)را به فهرست جستجو (ایندکس کردن) اضافه کرد و از نظر ارتباط آن با یک عبارت جستجو و یک جستجو ارزیابی کرد.

با مدیریت کرال کردن، خزنده موتور جستجو را به گونهای کنترل میکنید که تمام صفحات مرتبط با سئو، یعنی لینکهایی که برای فهرستبندی و رتبهبندی حیاتی هستند، تا حد امکان کرال و خزیده شوند. سپس مدیریت نمایه سازی کنترل می کند که کدام یک از صفحات خزیده شده واقعاً ایندکس شده باشند، یعنی باید در نتایج جستجو ظاهر شوند. در بین صفحاتی که در فهرست موتور جستجو گنجانده شدهاند، فاکتورهای رتبهبندی تعیین میکنند که کدام صفحه در نتایج جستجو در کجا ظاهر میشود.

کرال باجت یا بودجه خزیدن چیست؟

گوگل «بودجه خزیدن» مشخصی را به هر وب سایت اختصاص میدهد. این اصطلاح مقدار بازه زمانی را توصیف میکند که ربات برای خزیدن محتوای وب سایت صرف میکند. اگر صفحات «غیرضروری» را به ربات نشان دهید، بودجه خزیدن «هدر میرود»، یعنی صفحات مرتبط با رتبهبندی ممکن است بودجه خزیدن بسیار کمی داشته باشند.

کدام صفحات باید در کرال باجت شما گنجانده شود؟

برای رتبه بندی مهمتر از همه URL هایی هستند که نقطه ورودی مناسبی از جستجوی ارگانیک ارائه میدهند. به عنوان مثال، اگر میخواهید پروژه سئو سفارش دهید و به دنبال «شرکتهای مناسب سئو» هستید، صفحه ورودی مناسب صفحهای است که در آن مجموعهای از پکیجهای سئو در یک سایت نمایش داده میشود.

آیا صفحات محصول مربوط به رتبه بندی هستند؟

صفحات محصول عملا همیشه مرتبط با سئو هستند. هر فروشگاه آنلاین مایل است کاربران را از طریق جستجوی ارگانیک دریافت کند. با این حال، سوال این است: آیا می خواهید همه محصولات و انواع محصولات خود را بهینه کنید؟ اگر چنین است، آیا منابع لازم برای انجام این کار را دارید؟ بسته به اندازه فروشگاه آنلاین شما، با این حال، در عمل اغلب کمبود زمان یا پول برای بررسی تکه تکه همه محصولات و انواع آن وجود دارد.

در نتیجه، شما باید صفحات محصول خود را برای بهینه سازی اولویت بندی کنید:

- کدام محصولات پرفروشترین شما هستند؟

- کدام محصولات حاشیه خوب یا قیمت بالایی دارند؟

- کدام محصولات ورودی زیادی از جستجوی ارگانیک دارند؟

منظور این است که بعضی اوقات بهتر است روی محصول اصلی کار کنید تا روی انواع آن در سایت. برای مثال، ممکن است بسیاری عاشق آیفون 14 باشند و به دنبال آن بگردند! درست است، شاید بسیاری نیز در جستجوی خود فیلتر رنگ (مثلاً آیفون 14 مشکی) را اضافه کنند. اما بهتر است شما روی محصول اصلی یعنی آیفون 14 تمرکز کنید و آن را به کرالرها نشان دهید.

کدام صفحات باید خزیده شوند حتی اگر رتبه بندی نشوند؟

اگر یک صفحه نباید رتبه بندی شود، چرا باید برای سئو ضروری باشد؟ زیرا به صفحات مرتبط با رتبه بندی لینک میدهد. این صفحات برای کاربر ارزش افزودهای دارند، اما صفحات ورودی(لندینگ پیج) مناسبی نیستند. کرالرها همچنان باید به این صفحات نگاه کنند تا از طریق این «لینکهای داخلی» سایر صفحات مرتبط با رتبه بندی را در وب سایت بیابند.

کدام انواع صفحات مرتبط با سئو نیستند؟

هرازگاهی صفحاتی وجود دارند که حتی نیازی به کرال شدن ندارند. بنابراین آنها نه حاوی محتوای مرتبط با رتبه بندی هستند و نه چنین چیزی را نشان میدهند. صفحات ورود(صفحات لاگین یا ثبت نام در سایتهاا) مثال خوبی برای این موضوع هستند.

مثال دیگر صفحات فیلتری(در صفحات فروشگاهها معمولاً یک باکس برای فیلتر کردن محصولات وجود دارد) هستند که با رتبه بندی مرتبط نیستند. بسیاری از فروشگاه ها و بازارهای آنلاین به کاربران خود گزینههای فیلتر زیادی را ارائه میدهند که اکثر آنها را میتوان ترکیب کرد. برخی از آنها مطمئناً برای جستجو مرتبط هستند، به خصوص اگر کاربران نیز به دنبال آنها باشند.

نمونه های ملموس صفحات غیر مرتبط با خزیدن:

- صفحه خرید

- صفحات ورود

- URL ها را بدون ارتباط رتبه بندی فیلتر کنید

- انواع محصولات بدون ارتباط رتبه بندی

- صفحات نتایج جستجوی داخلی

بهترین فعالیت برای بهینه سازی خزیدن کرالرها در سایت

بنابراین تمام صفحاتی که برای رتبه بندی، نمایه سازی و خزیدن مرتبط هستند باید برای ربات موتور جستجو قابل دسترسی باشند. صفحات دیگر اما باید از او پنهان بماند.

از چه ابزارهایی می توان برای کنترل خزیدن سایت استفاده کرد؟

شما میتوانید از ابزارهای مختلفی برای کنترل خزیدن یک وب سایت استفاده کنید. برخی از آنها بیشتر برای اطمینان از خزیدن کافی (کنترل خزیدن مثبت)، برخی دیگر برای حذف صفحات خاصی از خزیدن (کنترل خزیدن منفی) خدمت میکنند.

سایت مپ

اساساً یک کرالر هر لینکی را که در یک وب سایت پیدا میکند دنبال میکند. این بدان معنی است که اگر ساختار لینک داخلی مرتبی داشته باشید، خزنده به طور حتم صفحات شما را پیدا میکند. همانطور که قبلا ذکر شد، گوگل به هر وب سایت بودجه خزیدن خاصی را اختصاص میدهد که نمیتواند تحت تأثیر قرار گیرد. بنابراین، شما دقیقا نمیدانید که خزنده هر چند وقت یکبار از یک صفحه بازدید میکند و چند و کدام صفحات را میخزد.

به همین دلیل، سایت مپ بسیار مفید است. نقشه سایت فایلی است که در آن می توانید تک تک صفحات وب سایت خود را فهرست کنید. به این ترتیب به گوگل و سایر موتورهای جستجو اجازه میدهید از ساختار محتوای وب سایت شما مطلع شوند. خزندههای وب موتورهای جستجو مانند Googlebot این فایل را میخوانند تا به خزیدن هوشمندانه وب سایت شما کمک کنند.البته به تازگی ربات دیگری به نام GoogleOther bot نیز به لیست رباتهای گوگل با شرح وظایف مشابه اضافه شده است.

نقشه سایت تضمین نمیکند که تمام محتوای موجود در آن واقعاً کرال و ایندکس شود. اما میتوانید از آن برای پشتیبانی از خزنده در کارش استفاده کنید.

چه زمانی باید از نقشه سایت استفاده کرد؟

نقشه سایت نقش اساسی در نمایه سازی یک وب سایت دارد. برای پروژه های کوچک و متوسط با صفحات فرعی کم و با لینکهای داخلی خوب، یافتن و خواندن تمام صفحات وب سایت برای خزنده مشکلی ندارد. با این حال، با پروژههای بزرگ و گسترده، این خطر وجود دارد که رباتهای موتورهای جستجو صفحات جدید در یک دامنه را نادیده بگیرند.

دلایل این امر می تواند:

- این وب سایت بسیار گسترده است، یعنی شامل صفحات فرعی زیادی است (به عنوان مثال فروشگاه آنلاین، پورتال آگهیها)

- وب سایت بسیار پویا است، با محتوای زیادی که مرتباً تغییر میکند (مثلاً فروشگاه های آنلاین بزرگ)

- صفحات محتوای فردی پیوند ضعیفی دارند یا حتی از یکدیگر جدا شده اند

- وب سایت جدید است و تنها چند لینک ورودی خارجی وجود دارد که به صفحات جداگانه وب سایت اشاره می کند

سایت مپ باید چه الزاماتی را برآورده کند؟

نقشه سایت در دایرکتوری ریشه وب سایت ذخیره میشود تا به راحتی توسط خزنده پیدا شود.

مثال: https://blogs.tooskaweb.com/sitemap.xml

الزامات رسمی زیر برای نقشه سایت اعمال میشود:

- حاوی URL های مطلق (به عنوان مثال https://www.ihrewebsite.de/)

- با فرمت UTF-8 کدگذاری شود

- فقط شامل کاراکترهای ASCII است

- حداکثر 50 مگابایت باشد

- حداکثر شامل 50000 URL باشد

بنابراین نقشههای سایت بزرگ باید به چندین نقشه سایت کوچکتر تقسیم شوند. سپس اینها باید از نقشه سایت شاخص پیوند داده شوند.

چه نوع نقشه های سایت وجود دارد؟

یک تمایز اساسی بین نقشه سایت HTML و نقشه سایت XML وجود دارد. دو نوع نقشه سایت نام خود را مدیون فرمت فایلی هستند که در آن ذخیره شده اند.

نقشه سایت HTML

نقشه سایت HTML بیشتر برای جهت دهی به کاربران در یک وب سایت استفاده می شود و به صورت داخلی پیوند داده می شود. وب سایت حاوی یک صفحه فرعی جداگانه است که در آن آدرس های وب (URL) منفرد در وب سایت ذکر شده است. کاربر روی یک URL کلیک می کند و مستقیماً به صفحه مورد نظر در وب سایت منتقل می شود. بنابراین با فهرست مطالب قابل مقایسه است

نقشه سایت XML

نقشه سایت XML از نظر ساختار با نقشه سایت HTML متفاوت است. این در قالب خاصی نوشته شده است و حاوی ابرداده های اضافی در مورد هر URL است، مانند تاریخ آخرین به روز رسانی، فراوانی تغییرات، اهمیت URL.

چگونه یک سایت مپ ایجاد کنم؟

راههای مختلفی برای ایجاد نقشه سایت وجود دارد. اکثر سیستمهای CMS و سیستمهای فروشگاهی از قبل عملکردی برای ایجاد نقشه سایت دارند. اگر از CMS (سیستم مدیریت محتوا) استفاده نمیکنید و می خواهید نقشه سایت خود را «خودتان» بسازید، مولدهای نقشه سایت متعددی وجود دارد.

robots.txt

پروتکل استاندارد حذف روباتها نحوه استفاده از فایل robots.txt را برای تأثیرگذاری بر رفتار روبات های موتور جستجو در دامنه خود تنظیم میکند. این پروتکل اکنون به یک شبه استاندارد تبدیل شده است.

درست است که استفاده از صفحه را میتوان در فایلهای HTML جداگانه با کمک متا تگ برای موتورهای جستجو نیز تعیین کرد، اما این فقط در مورد فایل HTML منفرد و حداکثر تمام صفحات داخل آن که قابل دسترسی هستند صدق میکند. از طریق پیوندها، اما نه به منابع دیگر مانند تصاویر. از طرف دیگر، در یک robots.txt مرکزی، میتوانید تعیین کنید که چه قوانینی باید برای دایرکتوریها و درختهای دایرکتوری اعمال شود، بدون توجه به فایل و ساختار مرجع پروژه وبتان.

از آنجایی که هیچ سند الزام آور وجود ندارد، تفسیر robots.txt و نحو آن همیشه توسط موتورهای جستجو به طور مداوم مدیریت نمی شود. بنابراین استفاده اضافی از متا تگ ها در فایل های HTML در موارد نمایه سازی ناخواسته توسط ربات توصیه می شود، اگر ربات robots.txt را به درستی تفسیر نکرده یا به اشتباه تفسیر کرده باشد.

فایل robots.txt به موتور جستجو می گوید که کدام صفحات یا فایل های یک وب سایت را میتواند و نمیتواند بخزد. صفحات منفرد، کل دایرکتوری ها یا انواع فایل های خاص را می توان از خزیدن حذف کرد. مهم است بدانید که ربات در ابتدا فرض می کند که مجاز است کل وب سایت را بخزد. بنابراین باید صراحتاً خزیدن صفحات یا انواع فایلهای جداگانه ممنوع باشد.

اگر قرار است یک وب سایت از فهرست بندی حذف شود، robots.txt وسیله مناسبی نیست. اگر خزنده را از دسترسی به بخشهایی از صفحه خود از طریق robots.txt منع کنید، میتواند این صفحات را ببیند اما آنها را نخواند. خزنده نمی تواند ببیند که آیا شما اطلاعات متا روبات هایی را ذخیره کرده اید که به عنوان مثال، نمایه سازی را ممنوع می کند.

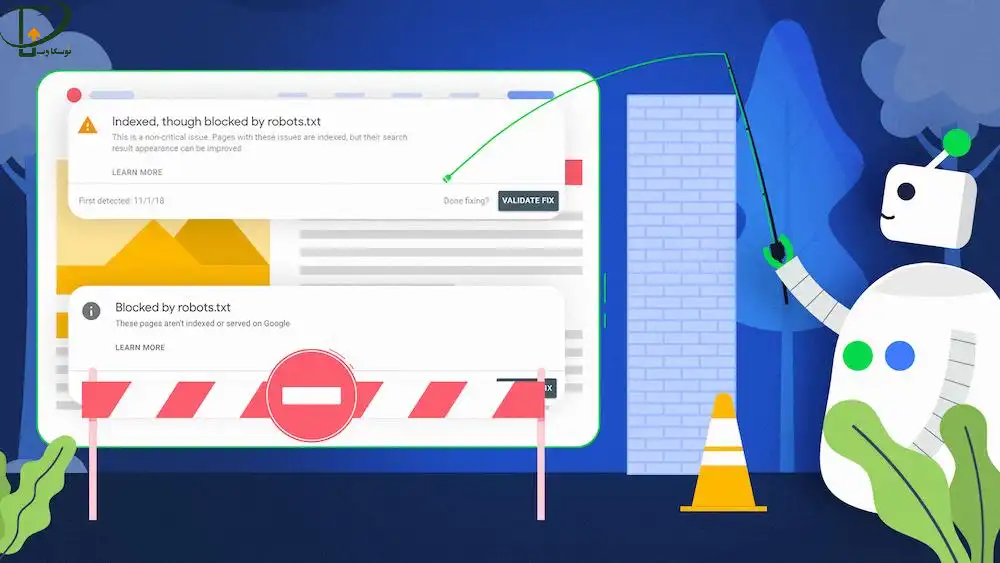

robots.txt فقط برای کنترل خزیدن ارتباط محدودی دارد. زیرا اگر صفحات دیگر یا خودتان به صفحات وب سایت خود که در robots.txt مسدود شده است مراجعه کنید، گوگل فکر می کند که باید مرتبط باشند زیرا به آنها ارجاع داده می شود. در نهایت ممکن است ایندکس شوند، زیرا خزنده نمی تواند بخواند که آیا باید در فهرست باشند یا نه. شما در نهایت او را از انجام این کار در robots.txt منع کردید. شما می توانید چنین صفحات مسدود شده ای را در جستجوی گوگل با این واقعیت تشخیص دهید که به جای توضیح معنی دار زیر URL: “هیچ اطلاعاتی برای این صفحه موجود نیست.”

میتوانید بفهمید کدام URLها در وبسایت شما از خزیدن در robots.txt مسدود شدهاند، اما همچنان فهرستبندی شدهاند، در «کنسول جستجو» در قسمت «پوشش»:

مهم است که به طور منظم پیام های موجود در کنسول جستجو را بررسی کنید و در صورت لزوم، بهبودهایی در وب سایت انجام دهید تا موتورهای جستجو بتوانند بدون مشکل وب سایت را بررسی کنند.

حرف آخر

تیم توسکاوب برای شما تعریف جامعی از کرال شدن و کرال باجت آماده کرده است و امیدواریم بتوانید با این اطلاعات سایت قویتری را برای خود داشته باشید.

0 Comments